ส่องวิวัฒนาการของแชตบอตปัญญาประดิษฐ์ตั้งแต่ยุคเเรกเริ่มจนถึงยุคที่เกิดข้อถกเถียงว่าเอไอจะมีความฉลาดเหนือมนุษย์หรือไม่

ปัญญาประดิษฐ์ หรือ AI เป็นหนึ่งหัวข้อที่ทั่วโลกพูดถึงอย่างมากในช่วงไม่กี่ปีที่ผ่านมา โดยเฉพาะอย่างยิ่งหลังจากบริษัท OpenAI เปิดให้ประชาชนทั่วไปใช้งาน Chatbot อัจฉริยะ Chat GPT ครั้งแรกๆ ในเดือนพ.ย.ปี 2022 จนทั่วโลกเริ่มเห็นศักยภาพของเทคโนโลยีดังกล่าวมากขึ้นและเกิดคำถามตามมาว่าท้ายที่สุดเทคโนโลยีอันชาญฉลาดนี้จะเข้ามาแทนที่มนุษย์หรือไม่

ที่เห็นได้อย่างชัดเจนคือในช่วงหนึ่งปีที่ผ่านมาบริษัททั่วโลกปลดพนักงานออกไปจำนวนมากจากการเข้ามาของ AI โดยตั้งแต่ต้นปีที่ผ่านมาบริษัทเทคโนโลยีชั้นนำของโลก 138 แห่งปลดพนักงานไปแล้วหลายหมื่นตำแหน่ง รวมทั้งเมื่อวันที่ 5 เม.ย.ที่ผ่านมา APPLE ปลดพนักงานอีกอย่างน้อย 600 คน

นอกจากนี้เมื่อช่วงปลายปีที่ผ่านมา Elon Musk เจ้าพ่อเทคโนโลยีเจ้าของบริษัท Tesla และนักวิทยาศาสตร์อีกกว่าร้อยชีวิตร่วมลงชื่อในจดหมายเปิดผนึกถึงบริษัท OpenAI ให้ยุติการพัฒนาโมเดลภาษาที่ล้ำหน้าไปกว่า Chat GPT-4 ชั่วคราวเพราะพวกเขากังวลว่าเทคโนโลยีดังกล่าวจะเข้ามาสร้างความปั่นป่วนต่อ “อารยธรรมของมนุษย์”

อย่างไรก็ตามบทความนี้จะพาผู้อ่านทุกท่านค่อยๆ พิจารณาพัฒนาการของ AI ตั้งแต่ในอดีตถึงปัจจุบันว่ากระบวนการเรียนรู้ของพวกมันเป็นอย่างไร เพราะในอีกด้านหนึ่งก็มีนักวิเคราะห์และนักวิทยาศาสตร์จำนวนมากเห็นต่างว่าแท้จริงแล้วเทคโนโลยีปัญญาประดิษฐ์ไม่ใช่ “พระเจ้า” ที่จะมีความสามารถหรือเข้ามาแทนที่อารยธรรมของมนุษย์ได้ เพราะพวกมันเป็นเพียงเทคโนโลยีที่ทำงานผ่านการคาดเดาทางสถิติรวมทั้งไม่ได้มีสติปัญญา จิตใต้สำนึก และวิจารณญาณเหมือนมนุษย์

จุดกำเนิดของ ‘สมองกล’

แนวคิดเรื่อง AI เกิดขึ้นมานานมากกว่าจุดกำเนิดของเทคโนโลยี โดยดร. Adrienne Mayor นักประวัติศาสตร์ที่มหาวิทยาลัย Stanford มีแนวคิดเกี่ยวกับ “เครื่องจักรที่สามารถคิดได้ด้วยตัวเอง” หรือ Thinking Machine มาก่อนด้วย

อย่างไรก็ตามแนวคิดดังกล่าวจํากัดอยู่แค่ในแวดวงวิชาการและความบันเทิงในการ์ตูนวิทยาศาสตร์ จนกระทั่งในช่วงกลาง-ศตวรรษที่ 20 คอมพิวเตอร์เริ่มมีประสิทธิภาพเพียงพอที่จะแก้ปัญหาและวิเคราะห์ทางสถิติได้อย่างมีประสิทธิภาพมากขึ้น

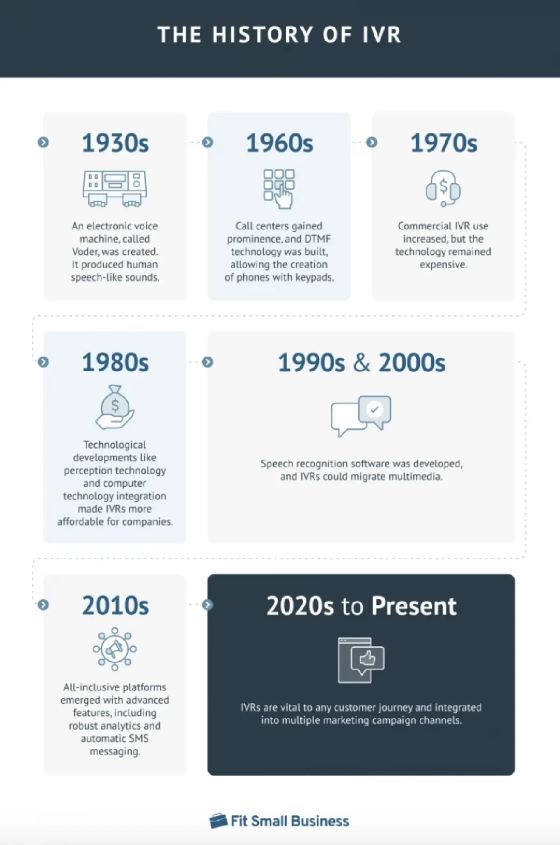

เค้าลางของวิวัฒนาการปัญญาประดิษฐ์เริ่มชัดเจนมากยิ่งขึ้นหลังจากในช่วงทศวรรษ 1930 นักวิทยาศาสตร์พัฒนา Interactive Voice Response (IVR) หรือ AI เริ่มต้นที่ผู้ใช้งานตอบโต้กับคอมพิวเตอร์ผ่านเสียงหรือการกดแป้นตัวเลขตามที่ผู้พัฒนาระบบตั้งค่าไว้

ยกตัวอย่างเช่น ผู้ใช้งานโทรไปหาคอลเซนเตอร์ของบริษัทหนึ่งแล้วระบบให้ผู้ใช้งานเลือกสิ่งที่ต้องการใช้บริษัท เช่นกดหนึ่งเพื่อคุยกับเจ้าหน้าที่ กดสองเพื่อชำระค่าบริการ และกดสามเพื่อฟังใหม่อีกรอบ โดยข้อดีของระบบ IVR คือสามารถบริการลูกค้าได้ตลอดเวลาโดยไม่ต้องใช้คนทำงานและเปิดโอกาสให้พนักงานไม่ต้องหน้าที่ที่จำเจและสามารถไปทำงานที่มีคุณค่ามากกว่าต่อไป

อย่างไรก็ตาม นอกจากข้อดีส่วนหนึ่งของระบบ IVR แล้ว AI ลักษณะนี้ยังมีข้อจำกัดจำนวนมาก หนึ่งในนั้นคือระบบการทำงานแบบนี้ทำให้ผู้ใช้งานต้องตอบคำถามหลายขั้นตอนก่อนที่พวกเขาจะได้สิ่งที่เขาต้องการ เช่น ต้องกดหนึ่ง แล้วกดสอง แล้วกดสามอีกครั้งกว่าที่จะได้คำตอบที่ต้องการ (Sub-options) จนอาจส่งผลให้ผู้ใช้งานเกิดความไม่พอใจและไม่กลับมาใช้งานอีกเลย หรือแม้กระทั่งการที่ระบบอัตโนมัติไม่สามารถตอบสนองความต้องการที่แท้จริงเพราะคำถามของผู้ใช้งานไม่ตรงกับสคริปต์ที่นักพัฒนาออกแบบไว้ได้

การมาถึงของ ELIZA

จากนั้นในช่วงทศวรรษ 1950 ถึง 1980 ความก้าวหน้าของ “Machine Learning” หรือเครื่องจักรที่สามารถเรียนรู้สิ่งต่างๆ ได้ด้วยเริ่มเกิดขึ้นและพัฒนาต่อไปอย่างก้าวกระโดดหลังจากนักวิทยาศาสตร์ในยุคนั้นพยายามหาแนวทางการพัฒนา AI ให้มีประสิทธิภาพมากขึ้น

หนึ่งในพัฒนาการสำคัญเกิดขึ้นระหว่างปี 1960 โดย Joseph Weizenbaum นักวิทยาศาสตร์จากสถาบันเทคโนโลยี Massachusetts พัฒนา ELIZA Chatbot เวอร์ชันแรกๆ ที่ทำงานตอบสนองกับผู้ใช้งานโดยมีบทบาทสมมุติเป็นนักจิตบำบัดผ่านการทำงานเชิงจิตวิทยาด้วยหลักการถามคำถามปลายเปิดกับผู้ป่วยโดยไม่ชี้แนะทิศทางคำตอบ หรือ Non-direct Consulting

ไวเซนบอมออกแบบการทำงานของ ELIZA ให้ปฏิบัติหน้าที่ภายใต้สคริปต์ที่ชื่อว่า DOCTOR ซึ่งเธอจะใช้ชุดคำถามที่ระบบตั้งค่าไว้ควบคู่ไปกับการนำคำตอบของผู้ใช้งานที่มีความสำคัญมากที่สุดในประโยคมาประกอบเป็นคำถามใหม่อย่างต่อเนื่อง ยกตัวอย่างเช่นหากผู้ใช้งานพิมพ์ข้อความไปหา ELIZA ว่า “I want to run away from my parents” ระบบจะให้คะแนนแบบถ่วงน้ำหนักคำศัพท์แต่ละคำโดยในประโยคดังกล่าว โดย ELIZA จะให้น้ำหนักกับส่วนขยายของประโยคมากว่าส่วนที่เป็นประธาน (I) และกริยาแท้ (want) นั้นก็คือคำว่า “to run away from my parents” เพราะเป็นส่วนที่มักเป็นส่วนที่บรรจุใจความสำคัญที่สุดของประโยคไว้

จากนั้น ELIZA จะใช้สคริปต์ที่ได้รับการเทรนมาสร้างประโยคใหม่เพื่อถามคำถามปลายเปิดต่อผู้ใช้งานอีกครั้ง เช่น ELIZA จะนำวลีที่มีน้ำหนักในประโยคแรกมาผสมกับสคริปต์ของเธอเพื่อถามคำถามต่อไปเช่น “What would getting to run away from your parents meant to you?” โดยเธอจะนำส่วนเดิมของประโยคแรกคือ “to run away from your parents” ประกอบเข้ากับสคริปต์ปลายเปิดของเธอที่ว่า “What would getting……….meant to you?”

ทว่าจากข้อจำกัดของทั้ง ELIZA และ IVR ที่ทำงานได้เพียงตามคำสั่งและสคริปต์ที่ผู้พัฒนาระบุไว้ นักวิทยาศาสตร์ขณะนั้นจึงพยายามหาทางทำให้ AI สามารถตอบสนองผู้ใช้งานได้อย่างตรงประเด็นและเฉพาะเจาะจงมากขึ้น

จนกระทั่งในช่วงปลายทศวรรษ 2000 และต้นทศวรรษ 2010 นักวิทยาศาสตร์เริ่มปรับใช้พัฒนาการเรียนรู้เชิงลึก (Deep Learning) หรือการพยายามจำลองให้เทคโนโลยีเรียนรู้ข้อมูลมหาศาลแล้วจำลองโครงข่ายของสมองคล้ายมนุษย์ขึ้นมาจนพวกมันสามารถทำงานและใช้เหตุผลที่ซับซ้อนมากขึ้นกว่าการทำงานตามสคริปต์ซ้ำๆ แบบ AI ยุคก่อนหน้า

‘อินเทอร์เน็ต’ จุดเปลี่ยนสำคัญของสมองกล

โดยจุดเปลี่ยนสำคัญคือเมื่อทั้งโลกเข้าสู่ยุคออนไลน์แบบเต็มตัวในช่วงทศวรรษ 2010 ซึ่งเป็นยุคของ “Big Data” หรือยุคที่ข้อมูลข่าวสารนั้นไหลวนอยู่ในโครงข่ายอินเทอร์เน็ตจำนวนมากทั้งหมดจึงถือเป็น “วัตถุดิบชั้นดี” ที่ทำงานสอดผสานกับพลังการประมวลผลของคอมพิวเตอร์ทำให้ปัญญาประดิษฐ์ทำงานได้อย่างมีประสิทธิภาพมากขึ้นด้วยโครงข่ายประสาทเทียมและอัลกอริทึม

จนท้ายที่สุดพัฒนามาสู่การเกิดขึ้นของ “Generative AI” หรือ AI แบบรู้สร้างซึ่งเป็นแขนงหนึ่งของปัญญาประดิษฐ์ที่สามารถสรรค์สร้างสิ่งต่างๆ ขึ้นมาได้ไม่ว่าจะเป็น ข้อความ รูปภาพ เสียง หรือวิดีโอ ภายใต้ข้อมูลที่ถูกเทรนมาด้วยโมเดลภาษาขนาดใหญ่ (Large Language Model: LLM) ที่ออกแบบโดยกลุ่มผู้พัฒนาภาษานั้นๆ

การทำงานของ Generative AI ทำงานโดยที่นักพัฒนาจะสร้างโมเดลภาษาขนาดใหญ่ขึ้นมาเพื่อสอนให้ระบบดังกล่าวสามารถ “เข้าใจ” ข้อมูลต่างๆ ที่อยู่ในโลกอินเทอร์เน็ตได้และเมื่อผู้ใช้งานระบุคำสั่งด้วยรูปประโยค (Prompt) ของภาษามนุษย์ปกติที่ไม่ใช้การเขียนโคดลงไป พวกมันก็จะประมวลผลจากข้อมูลทั้งหมดแล้วแสดงผลผ่านรูปแบบการเขียน รูปภาพ วิดีโอ หรือเสียง

ประเภทของโมเดลภาษาดังกล่าวประกอบด้วย (1) Base LLM โมเดลภาษาขนาดใหญ่ที่นักวิทยาศาสตร์สอนให้คาดเดาคำศัพท์ถัดไปที่จะเกิดขึ้นตามหลักการด้านสถิติและข้อมูลในอินเทอร์เน็ต เช่น “คนไทยต้องพูดภาษา…..” สิ่งที่โมเดลภาษานี้จะคาดเดาถัดไปจากหลักการทางสถิติและความน่าจะเป็นคือคำว่า “ไทย” ในขณะที่ (2) Instruction Tuned LLM โมเดลภาษาขนาดใหญ่ที่ทำงานตามคำสั่ง เช่นการตอบคำถามที่ผู้ใช้งานอยากรู้ โดยคำตอบนั้นจะออกมาได้หลากหลายรูปแบบขึ้นอยู่กับรูปประโยคของคำสั่งหรือ Prompt ที่ผู้ใช้งานป้อนเข้าไป

ปัญญาประดิษฐ์ฉลาดเหมือน ‘พระเจ้า’ (?)

ทั้งนี้ จะเห็นอย่างชัดเจนว่าการทำงานทั้งหมดของปัญญาประดิษฐ์ล้วนเกิดขึ้นมาจากการเรียนรู้ข้อมูลมหาศาลในโลกของอินเทอร์เน็ตผ่านการรับรู้ด้วยโมเดลภาษาแบบ LLM ที่นักพัฒนาสร้างขึ้นเพื่อให้พวกมันไปทำความเข้าใจข้อมูลเชิงลึกจนคล้ายกับว่าคอมพิวเตอร์มีโครงข่ายของเส้นใยประสาทเหมือนที่เกิดขึ้นกับสมองของมนุษย์ตอนที่เรียนรู้ข้อมูลใหม่ๆ ขึ้นมา ซึ่งข้อมูลทั้งหมดที่ปัญญาประดิษฐ์เรียนรู้ก็ยังเป็นข้อมูลที่สร้างขึ้นโดยมนุษย์

รวมทั้งต้องยอมรับว่าข้อมูลที่อยู่ในโลกอินเทอร์เน็ตที่ใช้เทรนสมองกลนั้นมีทั้งข้อมูลที่น่าเชื่อถือ ไม่น่าเชื่อถือ ข้อมูลที่บิดเบือน และข้อมูลที่ผิดไปจากข้อเท็จจริง ดังนั้นนักวิทยาศาสตร์และผู้พัฒนาจำนวนหนึ่งจึงยังไม่เชื่อว่าสมองกลเหล่านี้จะมีสติปัญญาสูงเหนือมนุษย์ราวกับเป็นเทพเจ้าตราบเท่าที่ข้อมูลที่พวกมันเรียนรู้ยังไม่ใช่ข้อมูลที่น่าเชื่อถือหนึ่งร้อยเปอร์เซ็นต์

มาถึงตรงนี้หากจะย้อนกลับไปถึงคำถามที่ว่าสมองกลเหล่านั้นจะมีสติปัญญาที่เหนือมนุษย์จนกลายไปเป็นเหมือนพระเจ้าหรือไม่อาจยังไม่มีคำตอบที่ชัดเจนในปัจจุบันเพราะยังมีความคิดเห็นที่หลากหลายในปัจจุบัน

ทว่าสิ่งที่เห็นอย่างชัดเจนในปัจจุบันคือภายใต้เทคโนโลยีปัญญาประดิษฐ์ที่ล้ำหน้า ที่สามารถตอบคำถามมนุษย์ได้อย่างคล่องแคล่ว พวกมันยังมีข้อผิดพลาดจากข้อมูลที่ไม่ถูกต้องซึ่งอาจนำมาสู่ความเสียหายจำนวนมากหนึ่งในนั้นคือการตอบคำถามของผู้ใช้งานที่ผิดจากความเป็นจริงด้วยความมั่นใจ (Hallucination)

ยกตัวอย่างเช่นมีผู้ใช้งานไปถาม Google Bard (ที่ปัจจุบันเปลี่ยนเป็น Gemini) เกี่ยวกับทฤษฎีและความหมายของเงินเฟ้อและท้ายที่สุดสิ่งที่เกิดขึ้นคือ Chatbot ดังกล่าวตอบคำถามผู้ใช้งานออกมาเป็นบทความหลายย่อหน้าพร้อมข้อมูลอ้างอิงจากตำราเศรษฐศาสตร์ภาษาอังกฤษจำนวนมาก ทว่าเมื่อผู้ใช้งานไปตรวจสอบชื่อหนังสือเหล่านั้นในอินเทอร์เน็ตกลับไปพบหนังสือเหล่านั้นในความเป็นจริง

ดังนั้นอาจพอสรุปได้ว่ายังมีพื้นที่ในการพัฒนาเทคโนโลยีปัญญาประดิษฐ์อีกมากกว่าที่พวกมันจะมีสติปัญญา (ที่มาพร้อมความถูกต้อง) เทียบเท่าหรือมากกว่ามนุษย์และก่อนที่จะไปถึงวันนั้น ผู้กำหนดนโยบายทั่วโลกควรหาทางรับมือกับความผิดพลาดของ AI ที่อาจนำมาสู่ความเสียหายต่อมนุษย์ก่อนที่กังวลว่าพวกมันจะฉลาดราวกับเป็นพระเจ้า

แหล่งข้อมูล